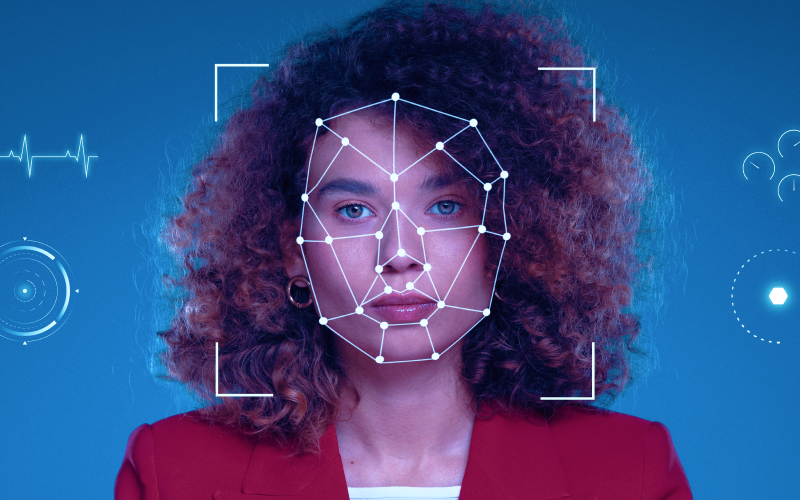

С внедрением в нашу жизнь нейросетей все острее становится вопрос регулирования контента, который генерирует искусственный интеллект. Дипфейки – имитацию чужого голоса или внешности – ловко используют мошенники в преступных целях. И для борьбы с ними необходимо предпринять ряд мер, которые в одном из последних интервью озвучил заместитель председателя Комитета Совета Федерации по конституционному законодательству и госстроительству Артем Шейкин.

Первая — необходимо законодательно ввести понятия искусственного интеллекта и дипфейка. Также сенатор предлагает ввести обязательную маркировку, так называемые водяные знаки, которые будут указывать, что контент создан с помощью нейросетей

«Если вы встречаете в информационном пространстве видеоролик или аудиозапись, в отношении которой у вас есть подозрения, что это продукт ИИ, но он не имеет пометки, это должно насторожить. Неправомерный контент должен оперативно удаляться», — считает Шейкин.

Зарубежный опыт

Ведущий научный сотрудник лаборатории социального моделирования ЦЭМИ РАН Сергей Гатауллин считает идею маркировки ИИ-контента посредством специальных машиночитаемых меток и текстового обозначения, доступного во время просмотра, вполне логичной. Законодатели опираются, в том числе, на зарубежный опыт. Так, например, в Китае такая маркировка уже успешно применяется. При этом за распространение дипфейков в КНР введено уголовное преследование.

Начальник отдела безопасности «СёрчИнформ» Алексей Дрозд обращает внимание на ситуацию в Южной Корее. Там из-за распространения ИИ статус массовой угрозы приобрела дипфейк-порнография.

«Только в прошлом году было задержано 387 подозреваемых, и более 80% из них — подростки. Хотя законодательство ужесточается, суды часто выносят мягкие приговоры, что не способствует снижению числа преступников», — отмечает он.

Алексей Дрозд вспоминает еще один кейс, когда пользователь Reddit сгенерировал в фото «девушки» с фальшивыми правами в руках. Изображение было очень убедительным и вызвало широкое обсуждение в сети.

«Прецедент показал риски использования неконтролируемых открытых моделей в создании поддельных документов», — отмечает он.

Еще один случай – использование нейросетей для генерации поддельных песен Фрэнка Оушена. Злоумышленник продал девять таких треков на музыкальных форумах как «утечку», заработав порядка 13 тысяч долларов.

Эффективно, но не абсолютно

Дипфейки, которые попали в руки мошенников, могут натворить много бед. И, конечно, инициатива правительства по введению ограничительных мер распространения контента созданного ИИ, вполне закономерна.

«Инициативные законодатели заботятся не только о благополучии граждан за счет создания доверенной цифровой среды, ведь с точки зрения противодействия социальной инженерии эффект совершенно не очевиден. Скорее речь идет о превентивном воздействии на возможность массовой манипуляции общественным мнением», — отмечает Сергей Гатауллин.

Андрей Дрозд уверен, что нанесение водяных знаков на весь контент, произведенный ИИ — это эффективная, но не абсолютная мера.

«Полностью искоренить дипфейки с ее помощью нереалистично. Всегда будут существовать открытые или «пиратские» модели без маркировки, а инструменты для удаления водяных знаков будут развиваться параллельно с их внедрением. Однако, если говорить о значительном снижении объема немаркированного фейкового контента в массовом информационном поле, то обязательная маркировка — это важный шаг. Когда человек видит метку «Создано ИИ», это включает критическое восприятие», — поясняет он.

Эксперт видит два пути, которые позволят минимизировать потенциальный ущерб от искусственного интеллекта. Первый — технологическая борьба. Речь как раз о маркировке контента.

«Это может быть явная маркировка (например, логотип в углу) или скрытая, которую видят только специальные алгоритмы», — говорит он.

А второй — административный. Необходимо создать понятные правила на платформах-распространителях контента.

«Они обязывают пользователей маркировать ИИ-контент, а сами внедряют системы проверки — считывание водяных знаков, собственные алгоритмы детекции (которые, впрочем, пока менее надежны), а также дают возможность любому пользователю подать жалобу на контент, указав соответствующую причину. За нарушение правил грозит удаление контента или блокировка аккаунта, но формально авторы могут оспорить вердикт», — рассказывает Алексей Дрозд.

Но, конечно, самая главная задача в борьбе с дипфейками — работа с населением. Граждане должны знать, какими инструментами могут пользоваться мошенники, глубже анализировать, проверять информацию, которую до них доносят. Благодаря их бдительности преступлений будет гораздо меньше, резюмируют спикеры.

Изображение создано Freepik, www.freepik.com